Die Bedeutung der Datenqualität für Analytics

- Analysis for Office, Predictive Analytics, Reporting

- analytics, data management, PDCA, sap analytics cloud

- 3 Min Lesezeit

Roger Heckly

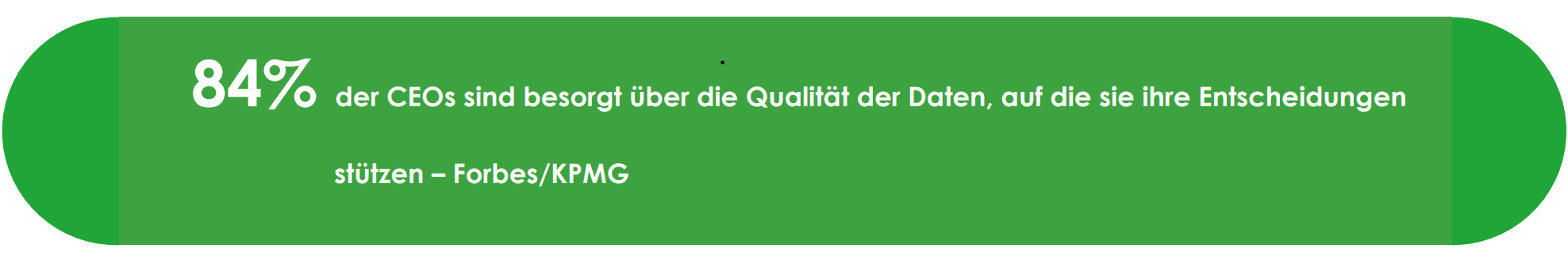

In der Welt der Analytics ist Datenqualität der Schlüssel zum Erkennen relevanter Muster und zum Treffen fundierter Entscheidungen. Nur durch präzise und verlässliche Daten können Unternehmen das volle Potenzial ihrer Datenanalyse ausschöpfen und wertvolle Erkenntnisse gewinnen. Mindere Datenqualität bedeutet mindere Einblicke – ein Luxus, den sich in der heutigen datengetriebenen Landschaft niemand leisten kann.

Inhaltsverzeichnis

Warum ist Datenqualität für Analytics von Bedeutung?

Data Driven Company oder datenbasierte Entscheidungen sind Ansätze, bei denen Firmen Entscheidungen aufgrund von Informationen fällen. Solche Informationen werden aufgrund von Definitionen von Systemen automatisch aufbereitet und in Reports oder Dashboards zur Verfügung gestellt.

Dabei verlässt man sich auf die Korrektheit, Vollständigkeit, Konsistenz und Aktualität der Informationen. Damit man der Qualität der Information vertrauen kann, ist es wichtig, dass die Datenquelle eine hohe Qualität aufweist.

Wie wird Datenqualität definiert?

Datenqualität bezieht sich auf die Genauigkeit, Vollständigkeit, Gültigkeit, Konsistenz und Relevanz von Daten. Wenn Daten von guter Qualität sind, sind sie verlässlich und können vertrauenswürdige Informationen liefern.

Was wird unter Analytics verstanden?

Warum ist Datenqualität für Analytics wichtig?

Die Datenqualität ist für Analytics von grosser Bedeutung, da sie direkten Einfluss auf die Qualität der Erkenntnisse und Entscheidungen hat. Nachfolgend werden einige wichtige Aspekte aufgezeigt, die im Zusammenhang mit Datenqualität stehen.

Analytics basiert auf Daten, und wenn diese fehlerhaft oder unvollständig sind, können die Ergebnisse unzuverlässig sein.

Eine gute Datenqualität stellt sicher, dass die Ergebnisse vertrauenswürdig und aussagekräftig sind.

Analytics zielt darauf ab, genaue Informationen zu gewinnen. Wenn die Datenqualität niedrig ist, können Fehler und Ungenauigkeiten zu falschen Schlussfolgerungen führen.

Hohe Datenqualität gewährleistet eine präzise Analyse.

Analytics wird häufig zur Unterstützung von Entscheidungen verwendet. Wenn die Datenqualität schlecht ist, können Entscheidungen auf falschen, verzerrten oder unvollständigen Informationen basieren.

Gute Datenqualität ermöglicht eine fundierte Entscheidungsfindung.

Datenintegrität ist definiert als die genaue und konsistente Aufrechterhaltung von Informationen während ihrer gesamten Lebensdauer. Datenintegrität bedeutet auch, dass es keine beschädigten Daten gibt.

Die Datenqualität unterstützt, dass relevante Daten in die Analyse einbezogen wird.

Um umfassendere Erkenntnisse zu gewinnen, werden Daten aus verschiedenen Quellen in einem Data Warehouse zusammengeführt und harmonisiert. Idealerweise haben gleiche Daten auch gleiche Typen und Schlüssel.

Hohe Datenqualität verringert die Komplexität in den Schnittstellen und den Aufwand der Harmonisierung und erhöht die Qualität der Analyse.

Um Prozesse zu automatisieren, muss ein System in der Lage sein, aufgrund der zugrunde liegenden Daten Entscheidungen treffen zu können. Z.B. automatisches Auslösen eines Serviceauftrags – ob dieser unter Garantie oder verrechenbar erstellt wird, hängt von den Stammdaten im Equipment ab.

Hochwertige Daten sind die Basis für Automatisierungen.

Welche Punkte gilt es bei der Datenqualität zu beachten?

- Vollständigkeit: Die Daten beinhalten sämtliche wichtigen Informationen oder Werte.

- Genauigkeit: Die Daten sind korrekt und präzise, um verlässliche Ergebnisse zu erzielen.

- Konsistenz: Die Daten sind in Bezug auf Formate, Werte und Einheiten konsistent, um eine korrekte Analyse zu ermöglichen.

- Aktualität: Die Daten sind jederzeit auf dem aktuellsten Stand.

- Datenvalidierung: Die Daten sind auf Plausibilität und Fehler überprüft, um ihre Qualität sicherzustellen.

- Datenbereinigung: Die Daten sind von Inkonsistenzen, Duplikaten oder Fehlerwerten bereinigt.

- OwnerShip: Es ist klar, in welchem Leading-System (OwnerShip) welche Daten von wem (Verantwortlichkeit) gepflegt werden.

Um obengenannte Punkte sicherzustellen, hilft es, gewisse Kontrollmechanismen (z.B. ein Stammdaten-Management-System) sowie einen Prozess für den Life-Cycle eines Objekts einzuführen, der z.B. folgende Fragen klärt:

• Wann / warum wird ein Objekt erstellt?

• In welchem System wird es von wem erstell?

…

Für einen tieferen Einblick in das Thema können Sie unser kostenloses Whitepaper herunterladen. Im Folgenden finden Sie eine kurze Zusammenfassung der Inhalte:

Inhaltsverzeichnis Whitepaper

- Sicherstellung der Datenqualität durch PDCA-Zyklus

- Wo sind die grössten Defizite bezogen auf Datenqualität bei Unternehmen vorhanden?

- Impact von Datenqualität in einem Business Prozess

- Welchen Mehrwert bietet mir als Endnutzer Analytics Software?

Webinar

SAP Datasphere & SAP Analytics Cloud Feature-Update in Q2/24

Datum: 28.05.2024

Uhrzeit: 08.30 – 09.15 Uhr

Sie möchten tiefer in dieses Thema einsteigen? Dann freuen wir uns auf den persönlichen Austausch zum Thema Datenqualität für Analytics!

Published by:

Roger Heckly

Roger Heckly

Wie hat Ihnen der Artikel gefallen?

Wie hilfreich war dieser Beitrag?

Klicken Sie auf einen Stern, um zu bewerten!

Durchschnittliche Bewertung 5 / 5.

Anzahl Bewertungen: 4

Bislang keine Stimmen! Seien Sie die erste Person, die diesen Beitrag bewertet!